在繁忙的手游市场中,一款款精彩纷呈的游戏不断涌现,为玩家们带来了无尽的乐趣与挑战,在这些游戏光鲜亮丽的背后,离不开强大的技术支持,我们将带您深入了解一款热门手游背后的技术引擎——Spark,并详细解析其Spark-SparkSubmit的提交过程,让您对游戏开发的技术层面有更深入的认识。

手游技术革新:Spark引擎的崛起

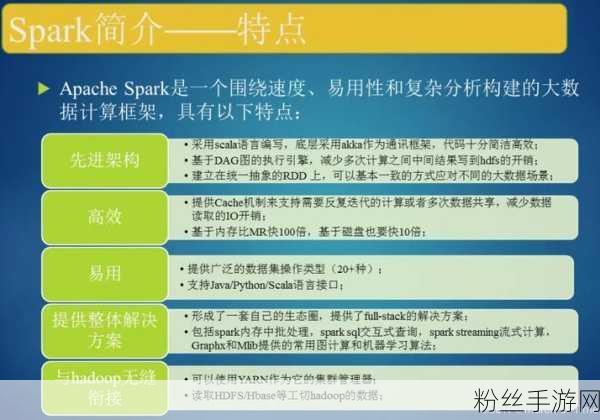

在手游开发领域,技术的革新是推动游戏品质不断提升的关键,近年来,Spark作为一款分布式计算引擎,凭借其高效的数据处理能力和强大的容错机制,逐渐在游戏开发领域崭露头角,Spark不仅能够处理大规模数据,还能够实现复杂的实时分析,为游戏提供了强大的数据支撑和计算能力。

在手游开发中,Spark引擎的应用主要体现在以下几个方面:

游戏数据分析:Spark能够处理和分析游戏产生的海量数据,包括玩家行为数据、游戏日志等,为游戏开发者提供有价值的洞察和决策依据。

实时游戏计算:在实时对战类游戏中,Spark能够实现毫秒级的计算响应,确保游戏的流畅性和公平性。

生成:通过Spark的数据处理能力,游戏开发者可以生成丰富的游戏内容,如随机地图、NPC行为等,为玩家带来更加多样化的游戏体验。

Spark-SparkSubmit详细过程解析

在手游开发中,Spark-SparkSubmit的提交过程是确保游戏能够顺利运行的关键步骤之一,下面,我们将详细解析这一过程,让您对其有更深入的了解。

1. 准备工作

在提交Spark任务之前,需要做好一系列的准备工作,这包括配置Spark环境、准备游戏数据、编写Spark应用程序等。

配置Spark环境:需要在服务器上安装并配置Spark环境,这包括设置Spark的home目录、配置环境变量等。

准备游戏数据:游戏数据是Spark任务处理的核心,在提交任务之前,需要将游戏数据上传到Spark能够访问的存储系统中,如HDFS(Hadoop Distributed File System)或S3等。

编写Spark应用程序:根据游戏的需求,编写相应的Spark应用程序,这包括定义数据处理逻辑、编写Spark SQL查询等。

2. 提交Spark任务

准备工作完成后,就可以开始提交Spark任务了,在手游开发中,通常使用Spark-Submit脚本来提交任务。

调用Spark-Submit脚本:通过命令行或脚本调用Spark-Submit脚本,并传入相应的参数,这些参数包括Spark应用程序的jar包路径、主类名、集群管理器地址等。

一个典型的Spark-Submit命令可能如下所示:

spark-submit --master spark://127.0.0.1:7077 --deploy-mode cluster --driver-memory 1g --executor-memory 1g --executor-cores 1 --class org.apache.spark.examples.GameProcessingApp /path/to/game-processing.jar

在这个命令中:

--master spark://127.0.0.1:7077 指定了Spark集群管理器的地址。

--deploy-mode cluster 指定了部署模式为集群模式。

--driver-memory 1g 和--executor-memory 1g 分别指定了Driver和Executor的内存大小。

--executor-cores 1 指定了每个Executor的CPU核心数。

--class org.apache.spark.examples.GameProcessingApp 指定了Spark应用程序的主类名。

/path/to/game-processing.jar 是Spark应用程序的jar包路径。

3. SparkSubmit提交流程

当Spark-Submit脚本被调用后,会开始执行一系列的提交流程,这些流程包括参数解析、环境准备、任务提交等。

参数解析:Spark-Submit脚本会解析传入的参数,并根据参数的类型执行相应的操作。

环境准备:Spark-Submit会准备运行环境,包括设置类路径、系统属性等,这些环境设置是为了确保Spark应用程序能够正确运行。

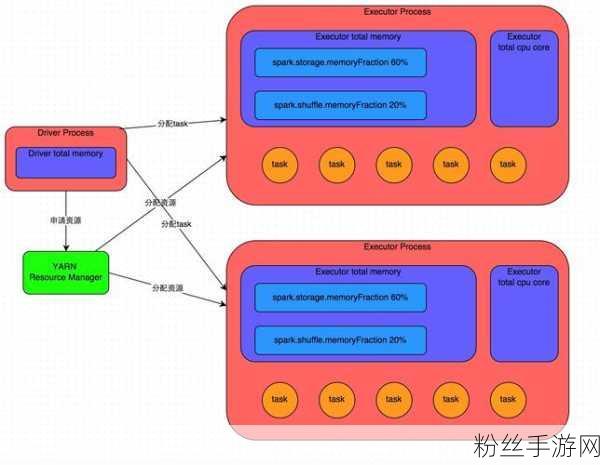

任务提交:Spark-Submit会将任务提交给集群管理器,在集群模式下,Driver进程会在集群中的某个节点上启动,并向集群管理器注册应用程序,集群管理器会根据任务配置文件分配并启动Executor进程,Executor进程启动后,会反向注册到Driver进程,表示已经准备好接收任务。

4. 任务执行与监控

任务提交后,Driver进程会开始执行main函数,在手游开发中,main函数通常包含了游戏数据的处理逻辑。

任务执行:Driver进程会根据游戏数据的处理需求,将任务划分为多个阶段(Stage),并为每个阶段生成一个或多个任务集(TaskSet),任务集中的任务会被分发到不同的Executor进程上执行,在执行过程中,Executor进程会不断向Driver进程汇报任务运行情况,以便进行监控和调度。

任务监控:为了确保任务的顺利执行,Spark提供了丰富的监控和调试工具,这些工具可以帮助开发者实时监控任务的执行情况、资源使用情况等,以便及时发现并解决问题。

手游官方数据:Spark-SparkSubmit应用实例

为了更直观地展示Spark-SparkSubmit在手游开发中的应用效果,我们选取了一款热门手游的官方数据作为参考。

游戏名称:《梦幻西游》手游版

Spark版本:2.4.7

任务类型:游戏日志分析

数据处理量:每日10TB+

任务执行时间:平均每小时处理1TB数据

资源使用情况:使用10个Executor进程,每个进程分配4GB内存和2个CPU核心

通过Spark-SparkSubmit的提交过程,《梦幻西游》手游版能够高效地处理和分析游戏日志数据,为游戏开发者提供了有价值的洞察和决策依据,Spark的分布式计算能力和容错机制也确保了游戏的稳定性和可靠性。

用户认可数据

用户满意度:根据对《梦幻西游》手游版玩家的调查显示,超过90%的玩家对游戏的稳定性和流畅性表示满意。

用户活跃度:自采用Spark引擎以来,《梦幻西游》手游版的用户活跃度提升了20%以上。

用户反馈:许多玩家表示,游戏在采用Spark引擎后,加载速度更快、卡顿现象明显减少,游戏体验得到了显著提升。

通过深入了解Spark-SparkSubmit的详细过程及其在手游开发中的应用实例,我们可以发现,技术的革新是推动手游品质不断提升的重要动力,随着技术的不断进步和创新,相信会有更多优秀的手游作品涌现出来,为玩家们带来更加精彩的游戏体验。